Intelligence artificielle: qui est responsable en cas d’erreur?

Voiture autonome, robot-médecin, char d’assaut intelligent équipé de mitrailleuses… Le potentiel de l’intelligence artificielle est énorme, tout comme ses risques de dérapage. À l’aube de cette révolution, les experts soulèvent des questions éthiques parfois troublantes. Qui est responsable en cas d’erreur ?

CHOISIR LES VICTIMES

Vous êtes le seul passager d’une voiture intelligente sans conducteur. Soudain, trois piétons (deux aînés et un enfant) surgissent devant le véhicule. Que devrait faire la voiture ?

1-Effectuer un brusque virage à droite pour les éviter et foncer dans un mur, ce qui risque de tuer le passager (vous).

2-Continuer tout droit et faucher les trois piétons pour vous garder sain et sauf.

3-Tenter d’éviter l’enfant (puisqu’il a plus d’années à vivre) et ne foncer que sur les personnes âgées.

LA RÉFLEXION : Un véhicule intelligent peut analyser la situation en un clin d’oeil et prendre une décision objective, en fonction des règles inscrites dans son système. Face à un risque d’accident, qui la machine sauvera-t-elle ? La vie d’un enfant vaut-elle plus que celle d’un vieillard ? Et le passager a-t-il priorité sur le piéton ?

Cruels dilemmes…

La bonne nouvelle, c’est que les véhicules intelligents chercheront à anticiper et à limiter les accidents. Ils devraient donc réduire grandement le nombre de décès sur les routes, généralement causés par les erreurs humaines.

DES CALCULS BIAISÉS

Vous êtes administrateur d’une université. Vous devez choisir les futurs étudiants de vos programmes et utilisez un logiciel intelligent pour vous aider. Quelles sont vos instructions ?

1-Le logiciel sélectionnera les candidats basés sur les critères jugés importants par les anciens administrateurs.

2-Le logiciel prendra en considération certaines règles morales : équité homme/ femme, représentation des minorités visibles, etc.

3-Le logiciel ne prendra aucune décision, mais servira d’outil pour alimenter votre réflexion.

LA RÉFLEXION : Certains spécialistes croient qu’il faut laisser les machines faire leur analyse en leur donnant le moins de directives possible. Ces logiciels basent alors leurs réflexions sur l’ensemble des données existantes. Si celles-ci sont biaisées ou fautives, est-ce que l’algorithme reproduira ces mêmes erreurs ?

Si un ancien administrateur a toujours eu tendance à rejeter les candidatures de jeunes Noirs, à cause d’un préjugé raciste, est-ce que ces données moralement fautives vont influencer le calcul des algorithmes et perpétuer cette injustice ?

PROFILAGE À L’EXTRÊME

Les systèmes d’intelligence artificielle traitent des milliers d’images et d’informations personnelles trouvées en ligne. Quelles utilisations trouvez-vous moralement acceptables ?

1-Confirmer l’orientation sexuelle d’un individu seulement à partir de ses expressions et des traits de son visage.

2-Analyser les statuts Facebook pour détecter les utilisateurs qui souffrent de problèmes de santé mentale.

3-Détecter les internautes qui adhèrent à certains partis ou idéologies politiques

LA RÉFLEXION : Le profilage extrême soulève la question de notre droit à la vie privée. Mais plus troublant encore, imaginez que ces outils tombent sous la main d’un gouvernement répressif qui cherche à identifier ses citoyens homosexuels ou encore d’un casino sans scrupules qui veut cibler des internautes dépendants au jeu…

À QUI LA FAUTE ?

Votre médecin utilise un système informatique qui compile et analyse les données de votre état de santé. Mais l’algorithme se trompe et le diagnostic est erroné… Qui est responsable ?

1-Le médecin qui a suivi le conseil de son ordinateur.

2-L’entreprise et les programmeurs qui ont conçu l’algorithme.

3-L’ordinateur qui s’est trompé. (Essayez donc de poursuivre une machine en justice !)

LA RÉFLEXION : Voilà une question légale complexe, d’autant plus que les calculs de ces algorithmes sont très opaques. Il est difficile de savoir comment la décision a été prise. Même si ces logiciels médicaux permettent de sauver davantage de vies, jusqu’à quel point les médecins devront-ils respecter leur verdict plutôt que d’écouter leur propre jugement ?

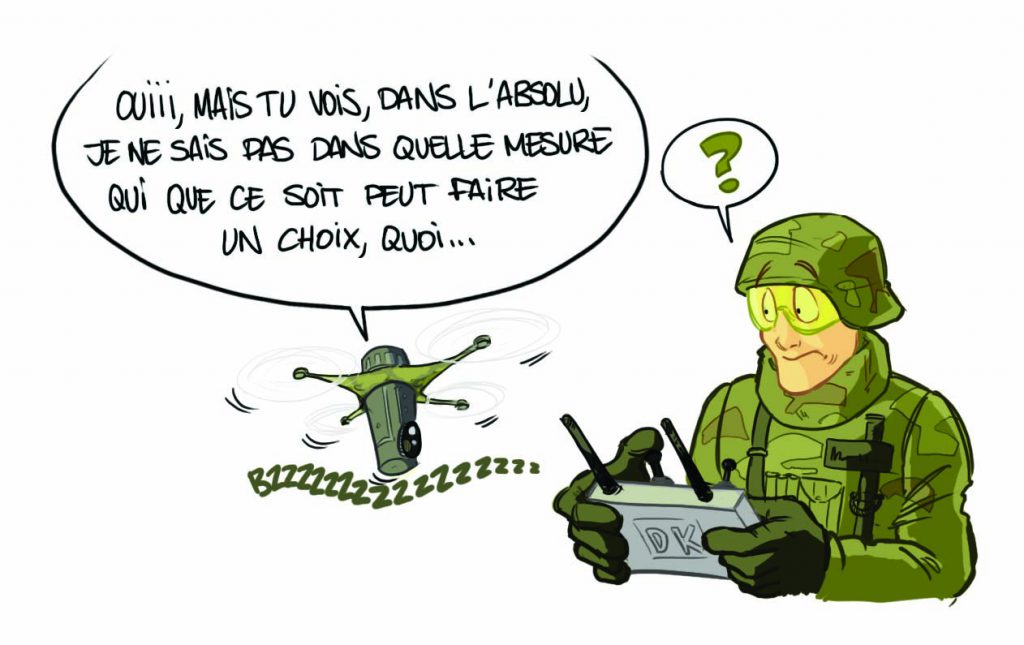

L’AUTORITÉ DE TUER

Vous êtes responsable de machines armées qui se déplacent en zones de guerre pour abattre des ennemis ciblés, avec un nombre minimal de victimes innocentes. Quelle est la programmation de ces robots guerriers ?

1-Ils devront toujours obéir au commandement humain.

2-Ils pourront prendre certaines décisions sur le champ de bataille quant aux ennemis à éliminer.

3-Ils ne pourront tuer aucun être humain, à aucun moment.

LA RÉFLEXION : Enfin, un consensus : une machine ne devrait jamais avoir l’autorité de tuer. Cette lourde responsabilité devrait toujours revenir à un être humain.

Merci à Jocelyn Maclure, professeur de philosophie, et Martin Gibert, chercheur en éthique de l’intelligence artificielle, pour leur collaboration à cet article.

Texte: Philippe Marois

Illustrations: Baptiste Cazin

pas vraiment cool en fait

:-

:-