L’intelligence artificielle en observation

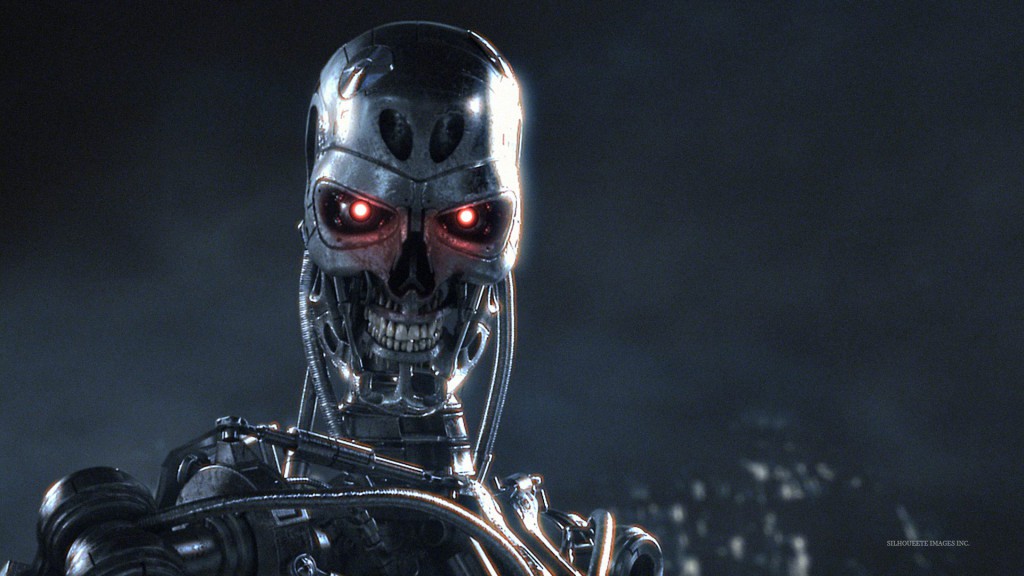

Malgré l’arrivée du dernier épisode de la saga Terminator sur nos écrans, qui s’intéresse aux véritables enjeux et aux risques que pose l’intelligence artificielle de demain? Certainement, le Future of Life Institute. Soutenue entre autres par Elon Musk, Stephen Hawking et Bill Gates, l’organisation vient de dévoiler la liste de 37 projets de recherche qu’elle parrainera afin d’éviter que des machines super-intelligentes ne mettent la planète en pièces et n’éradiquent l’humanité. Scénario catastrophe digne d’Hollywood? Peut-être.

Financés par le biais d’un don de 10 millions de dollars d’Elon Musk, fondateur de PayPal et de SpaceX, les boursiers exploreront des concepts permettant de pallier certaines conséquences inattendues et catastrophiques du développement de l’intelligence artificielle (IA). Nébuleux? Pas tant que ça.

Si vous êtes anxieux à l’idée de voir le monde de demain peuplé de cyborgs mercenaires à la sauce Terminator ou de « réplicants » version Blade Runner, respirez un peu ou prenez un Valium! Le Future of Life Institute vous invite à ne pas confondre science-fiction et réalité.

Le monde d’aujourd’hui est déjà peuplé de drones, des armes pilotées à distance. Demain, les champs de bataille seront peut-être survolés par des drones super-intelligents ou arpentés par des robots-soldats autonomes. Pour s’assurer qu’ils ne dérapent pas, qu’ils n’échappent pas au contrôle humain et dénaturent les conflits, il faut tracer des frontières claires. C’est ce qu’étudiera le professeur Heather Roff Perkins de l’Université de Denver au travers de son projet intitulé Lethal Autonomous Weapons, AI and Meaningful Human Control (bourse de 136 918 $).

À l’heure de la transparence tous azimuts, la professeure Manuela Veloso de l’Université Carnegie Mellon University (bourse de 200 000 $) exigera des systèmes d’IA d’expliquer aux humains leurs décisions et leurs actions. En détail, s’il vous plaît! On ne parle pas ici de demander à un thermostat pourquoi il a déclenché la climatisation en plein hiver. Pensons plutôt au robot-chirurgien capable de vous retirer l’appendice ou au robot-infirmier susceptible de prescrire des médicaments par exemple.

Et pour éviter les prises d’otage à la Skynet dans Terminator 3 ou la rébellion de Hal dans 2001, L’Odyssée de l’espace, Benja Fallenstein du Machine Intelligence Research Institute (bourse de 250 000 $) étudiera comment neutraliser ou reprogrammer les machines pour aligner leurs intérêts à ceux des humains. De quoi prévenir toute éradication de la race humaine si un ordinateur central à la fibre écologique se mettait en tête d’optimiser les ressources de la planète.

Tous ses projets laissent entrevoir les questions éthiques et philosophiques derrière l’intelligence artificielle. L’homme sera-t-il suffisamment intelligent pour accoucher d’une IA fiable, sécuritaire et bénéfique pour tous? Comment l’IA de demain pourra agir prudemment dans un monde peuplé d’inconnus inconnus (« unknown unknowns »), un aspect que les concepteurs d’IA n’ont pas du tout anticipé? », rappelle Thomas Dietterich, boursier et président de l’Association for the Advancement of Artificial Intelligence, dans un communiqué de presse.

Souhaitons donc bonne chance à Nick Bostrom de l’Université d’Oxford qui s’intéressera à ces questions philosophiques à 1,5 million de dollars au travers du futur Institut de recherche pour l’intelligence artificielle regroupant les forces vives des Universités d’Oxford et de Cambridge.

Les projets de recherche débuteront en septembre 2015 et seront financés pour trois ans maximum. Après cette étape, les projets les plus prometteurs se partageront 4 millions de dollars additionnels retenus sur le don initial d’Elon Musk.

Bruno Geoffroy — Agence Science-Presse (www.sciencepresse.qc.ca)

publiez votre commentaire

dites-nous ce que vous en pensez